阿里发布最新视觉推理模型QVQ

到年底了,AI大模型迭代继续突飞猛进。

近日阿里云发布视觉推理模型QVQ,并且全部开源,业界首次开源此类模型,阿里云再次第一。

多项评测结果显示,QVQ的整体性能超越了此前备受赞誉的视觉理解开源模型「Qwen2-VL」,并在综合能力上与顶级推理模型如 OpenAI o1 和 Claude3.5 Sonnet 的「满血版」相媲美:

上图中的测试题目难度较大,看到新模型QVQ在MathVista上取得了71.4分,超越了O1,位居第一名。

如下图所示MathVista数据集是基于视觉上下文测评数学推理能力的:

要想正确回答这个数据集的测试题目,必须要看懂图的前提下,有了很强的数学推理后,才能够正确作答,如下是MathVista数据集的三道测试题,大家感受下题目难度情况:

作为视觉推理模型,QVQ的第一大特性就是具备很强的视觉理解能力,比如下面这个图片内文字,由于字体原因难以识别出来:

交给QVQ模型,识别汉字准确率达到100%:

这种事情交给GPT4o,就比较难为它,它让我安装中文OCR语言包去识别,不然就无法识别图片内的文字出来:

O1就有些离谱了,竟然输出了大江东去:

事实上,人类是通过语言和视觉相结合,来感知和理解世界的。同理如果要AI更像人,可以教它同时学会感知文字、图片、公式、视频等多种输入知识,这就是多模态能力,如下图所示,除了输入常见的文字外,图片1,2,3,再加1个视频,全部输入给AI,让它统一编码学习。

验证了QVQ的视觉能力后,它还有第二大特性,就是科学问题的复杂推理能力,具体表现为足够详细的思考过程、中间还有自我质疑和反思。

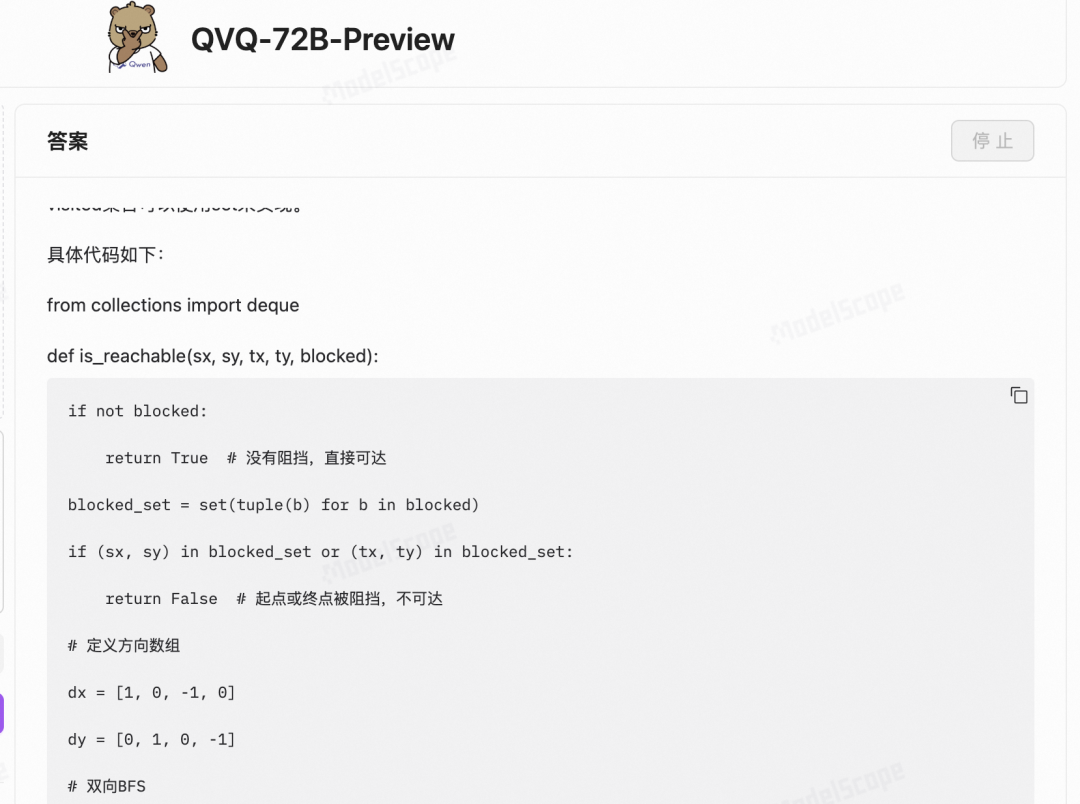

通过QVQ开源模型验证。下面是我提问它的一道编程题,逻辑难度比较大,不会深入思考,肯定是无法求解出来的。

下面是它的回复,从中我们可以看到模型输出了足够详细的思考过程、中间还有自我质疑和反思,经过几轮后,历时2分06秒思考,最终输出求解代码。下面是它完整的思考视频,我把它录制出来一起看下,感兴趣的可以观看下:

Your browser does not support the video tag.

中间QVQ会有自我质疑和反思。

具体来说,在求解此题时,经历的步骤包括:分析题目,提出求解方案A,验证方案A,否定求解方案A;

提出新的求解方案B,验证方案B,初步认可方案B,继续优化方案B,再优化B,验证优化,确认优化可行;

开始构思方案B的代码实现细节,编写代码,最后再验证代码,总结求解此题过程。

下面我来展示几个关键步骤。首先,QVQ选择了BFS来尝试求解:

但是很快它就发现普通BFS不是好的求解策略,因为网格搜索空间大:

并很快探索出了双向BFS可以提高探索效率:

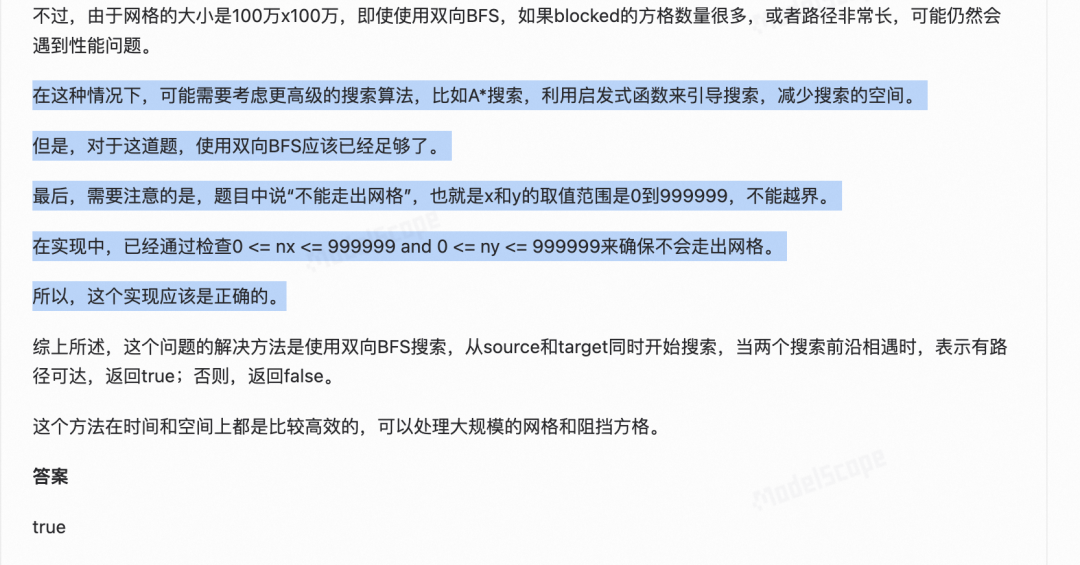

多次自我探索、自我验证、自我质疑后,QVQ提出了确认了最后的方案:

倒数第二步,开始思考代码实现的具体细节:

最后一步给出求解代码(部分截图展示):

最后还会总结和验证代码:

以及最终求解代码(部分截图,详细求解代码参考上面的视频):

总结一下

QVQ是阿里全新的多模态推理模型,通过验证看到,QVQ结合视觉+推理后,进一步变强了!O1无法识别的问题,高难度的编程题,QVQ加载视觉推理后,都能正确求解了。

QVQ关键是它还是开源、免费的,人人都能下载和体验,省钱,也为AI技术的前沿研究提供了强大的技术支持。

以上全文1686字,16图和视频。