3 LangChain概述:什么是LangChain?

在上一篇中,我们探讨了LangChain的应用场景,它如何帮助开发者构建与语言模型的互动。接下来,我们将深入了解LangChain本身,了解它的核心定义以及它如何实现这一愿景。

什么是LangChain?

LangChain 是一个用于构建基于语言模型的应用程序的框架,旨在简化与大型语言模型(如GPT-3和其他AI模型)的集成。它提供了一系列工具和接口,以帮助开发者快速构建出强大的自然语言处理(NLP)应用。

LangChain的关键特点

-

模块化构建:LangChain允许开发者通过模块化组件来设计应用,这种方式使得各个功能部分可以灵活组合。例如,你可以单独使用

文本处理模块、问答模块或记忆模块,然后将它们连接在一起形成完整的应用。 -

多样的集成:它支持多种语言模型的集成,无论是OpenAI的模型、Hugging Face的模型,还是其他的自定义模型,开发者都可以轻松地将其融入到自己的项目中。

-

灵活性:LangChain允许用户自定义工作流,以适应特定应用的需求。例如,在某些情况下,你可能需要一个能够持续学习用户偏好的智能助手,这时LangChain的记忆机制将派上用场。

-

易于调试和测试:框架内置了多种调试工具,开发者可以快速测试和优化模型的性能,这对于持续的迭代开发至关重要。

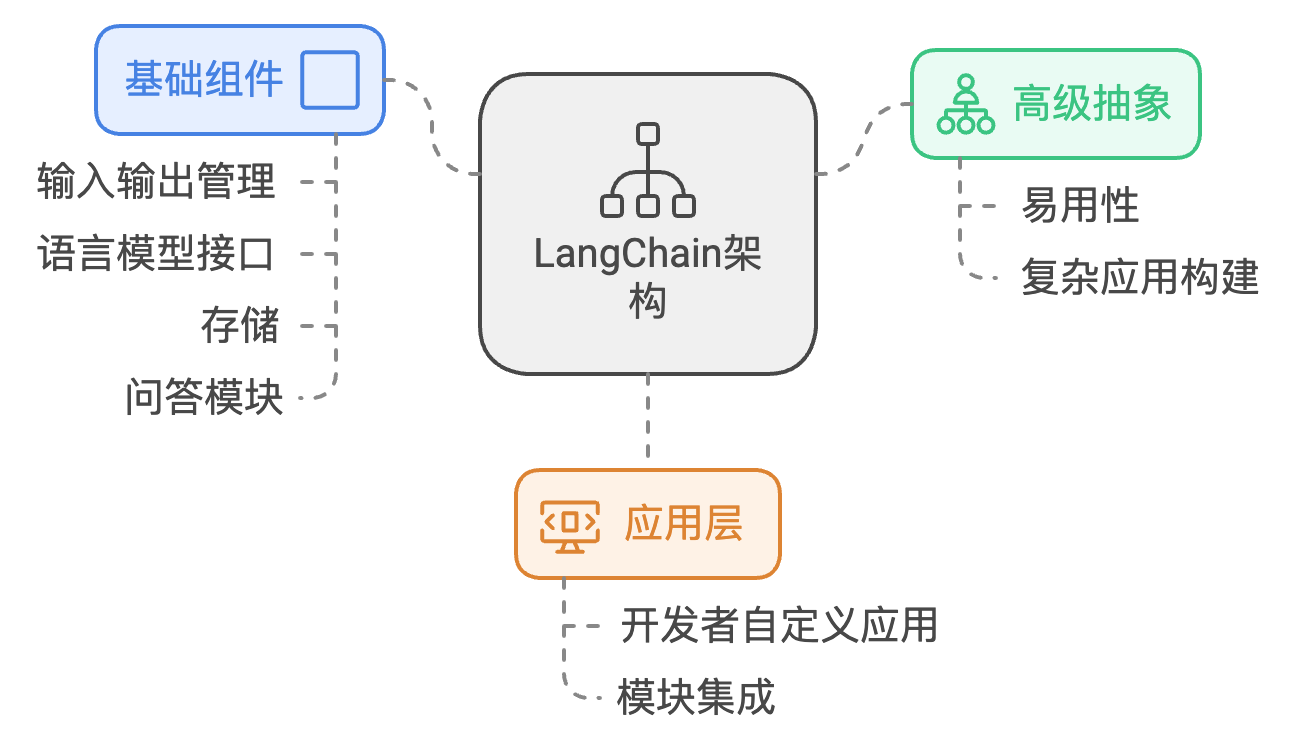

LangChain的架构

LangChain的架构可以主要分为几个层次:

-

基础组件:这些包括输入输出管理、语言模型接口、存储和问答模块等。

-

高级抽象:在基础组件的基础上,LangChain提供了一些容易使用的高级抽象,使得构建复杂的应用变得更加简单。

-

应用层:最终,开发者可以在这个层面构建自己的应用程序,集成各种模块来实现特定功能。

案例:构建一个简易对话机器人

为了更好地理解LangChain,我们来看一个简单的案例,构建一个能够回答基本问题的对话机器人。

from langchain import ConversationChain, OpenAI

from langchain.memory import ConversationBufferMemory

# 初始化语言模型

llm = OpenAI(model_name="gpt-3.5-turbo")

# 创建记忆机制,用于追踪对话历史

memory = ConversationBufferMemory()

# 创建一个对话链

conversation = ConversationChain(llm=llm, memory=memory)

# 开始对话

response1 = conversation.predict(input="你好!你能告诉我LangChain是什么吗?")

print(response1) # 输出机器人回答

response2 = conversation.predict(input="它有什么用呢?")

print(response2) # 输出机器人的进一步回答

在这个例子中,我们利用ConversationChain构建了一个基本的对话机器人,它可以根据上下文进行回答。通过使用ConversationBufferMemory,机器人能够追踪对话历史,从而提供更相关的回复。

小结

LangChain 提供了一个强大的环境用于构建基于语言模型的应用,尤其是在与用户互动的场景中。通过模块化和灵活性,开发者可以根据需求快速搭建和修改项目。

在下一篇文章中,我们将深入探讨LangChain的核心概念,这将帮助我们更好地理解如何利用这个工具来构建复杂的应用程序。