15 DeepSeek接入远程算力,管理个人知识库,确实可以封神了!

这段时间有读者跟我留言反馈了一个问题,就是自己电脑即便运行deepseek-r1最小的1.5b模型,提问它一个问题,也迟迟无法得到回复,好像完全卡顿在那里。

这个问题还不是个别人遇到过,貌似还挺多的,所以今天这篇文章来探索一个对此问题的解决方法。尤其是个人电脑配置不是很好,比如不带GPU显卡,而是传统的intel显卡的电脑,无法运行大模型的,可以好好看看。

除此以外,这篇文章还会介绍如何借助大模型搭建个人知识库。

1 解决方案

既然本地算力跟不上,那么咱们就寻求远程算力,让远程算力接入咱们的电脑,推理计算完全不在自己的电脑上,哪怕是电脑配置好的读者但不想耗费自己电脑算力的,都可以使用远程算力。

因此解决方案,总结下来一句话,调用远程大模型算力。

写这篇文章前我调研了不同平台,发现腾讯云的高性能应用服务HAI,对小白最为友好,主要基于两个原因:

第一,这个平台的算力接入到本地个人电脑,完全零代码实现,这个对于不懂编程的朋友就很重要了;

第二,算力模型支持DeepSeek-R1,并且支持不同参数尺寸,从1.5B, 7B, 8B再到满血版671B等全尺寸支持.

算力问题解决后,文章后半部分会介绍,使用腾讯云HAI如何接入我开发的个人知识库软件,实现对个人文件的有效管理。

2 腾讯云HAI算力接入个人电脑

现在腾讯云HAI上线了CPU版1元体验活动,相当于白嫖了!他们预装了DeepSeek-R1 1.5B、7B、8B、14B、32B等五个尺寸的蒸馏模型,这里以CPU版为例给大家演示HAI算力如何接入个人电脑。

每个步骤我会给大家尽量描述详细,大家只需按照我的步骤操作,其实一共只用简单三步就能直接用上DeepSeek-R1,简直不能再方便了。

步骤一,打开腾讯云,网址如下:

https://console.cloud.tencent.com

步骤二,首页找到高性能应用服务HAI,界面如下所示:

选择1元体验HAI-CPU体验版,CPU算力16核32GB:

第三步:过1分钟左右,CPU算力就会申请下来,然后点击下面网址:

https://console.cloud.tencent.com/hai/instance?rid=1

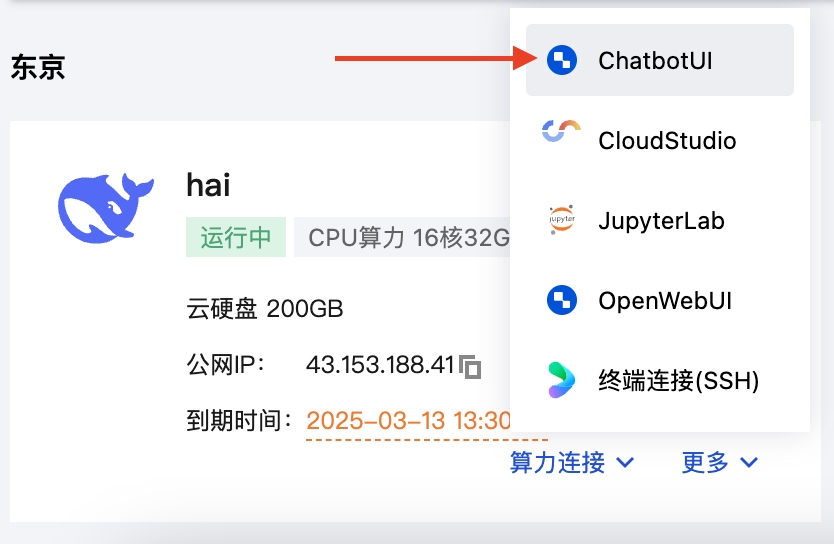

就会看到申请的CPU算力HAI, 我们主要用到公网IP,大家复制下保存到自己的电脑:

默认目前HAI已经接入了如下5个平台:

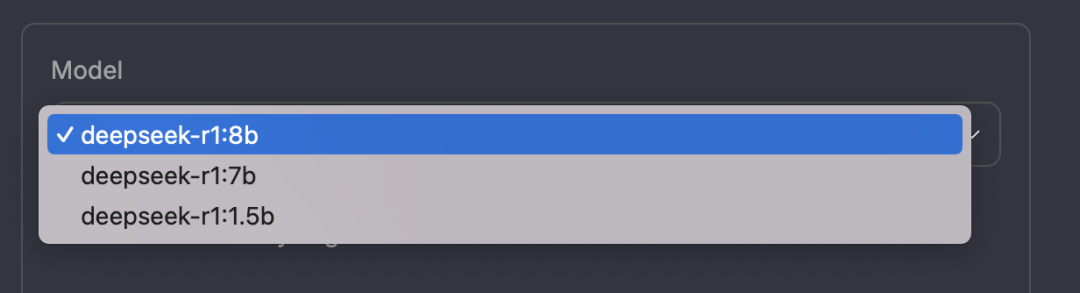

比如第一个ChatbotUI,大家点击下就可以直接使用上deepseek-r1:8b, 7b, 1.5b的模型了:

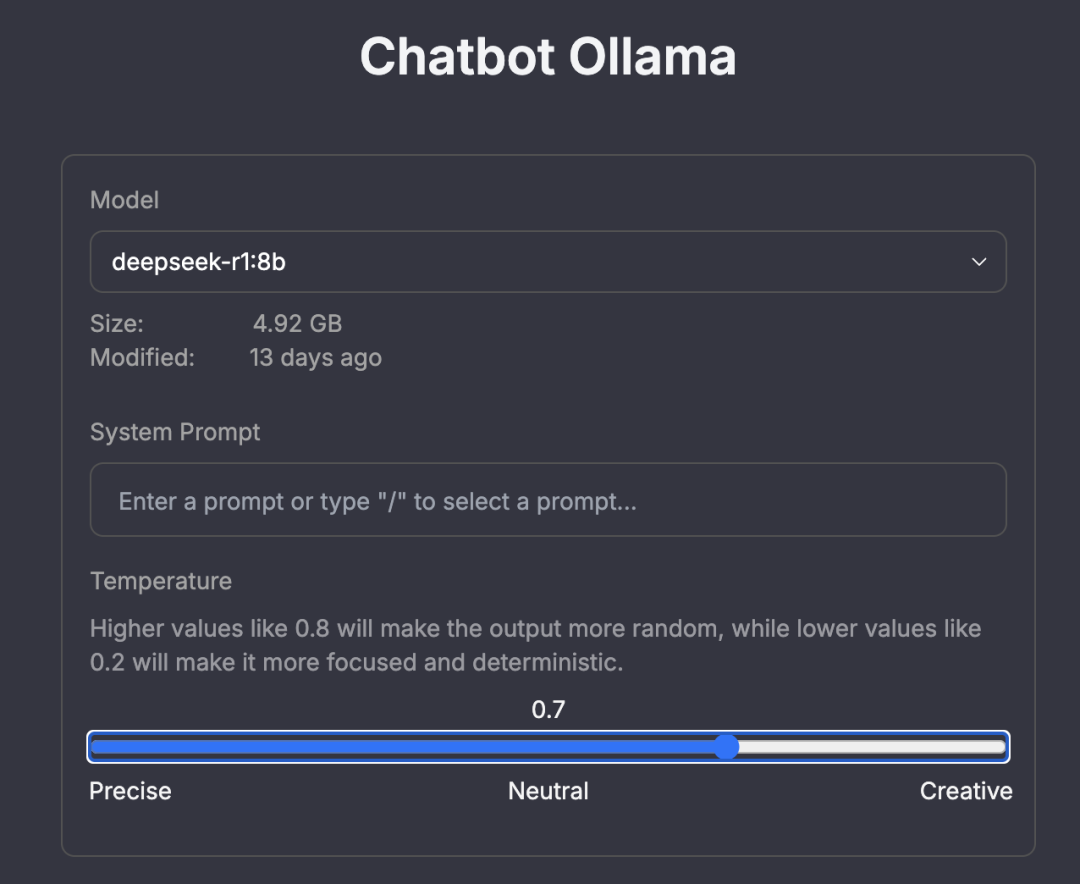

可以对话试试,温度调为0.7,这样兼顾规律知识和创新:

其他模型大家可以点点探索下,都是零代码使用,我就不再介绍了,下面重点说说如何使用HAI算力在本地电脑管理个人知识库。

3 基于HAI管理个人知识库

HAI为我们提供了DeepSeek-R1的算力支持,根据它提供的公网IP+端口,然后就可以接入在本地运行的个人知识库管理软件了。

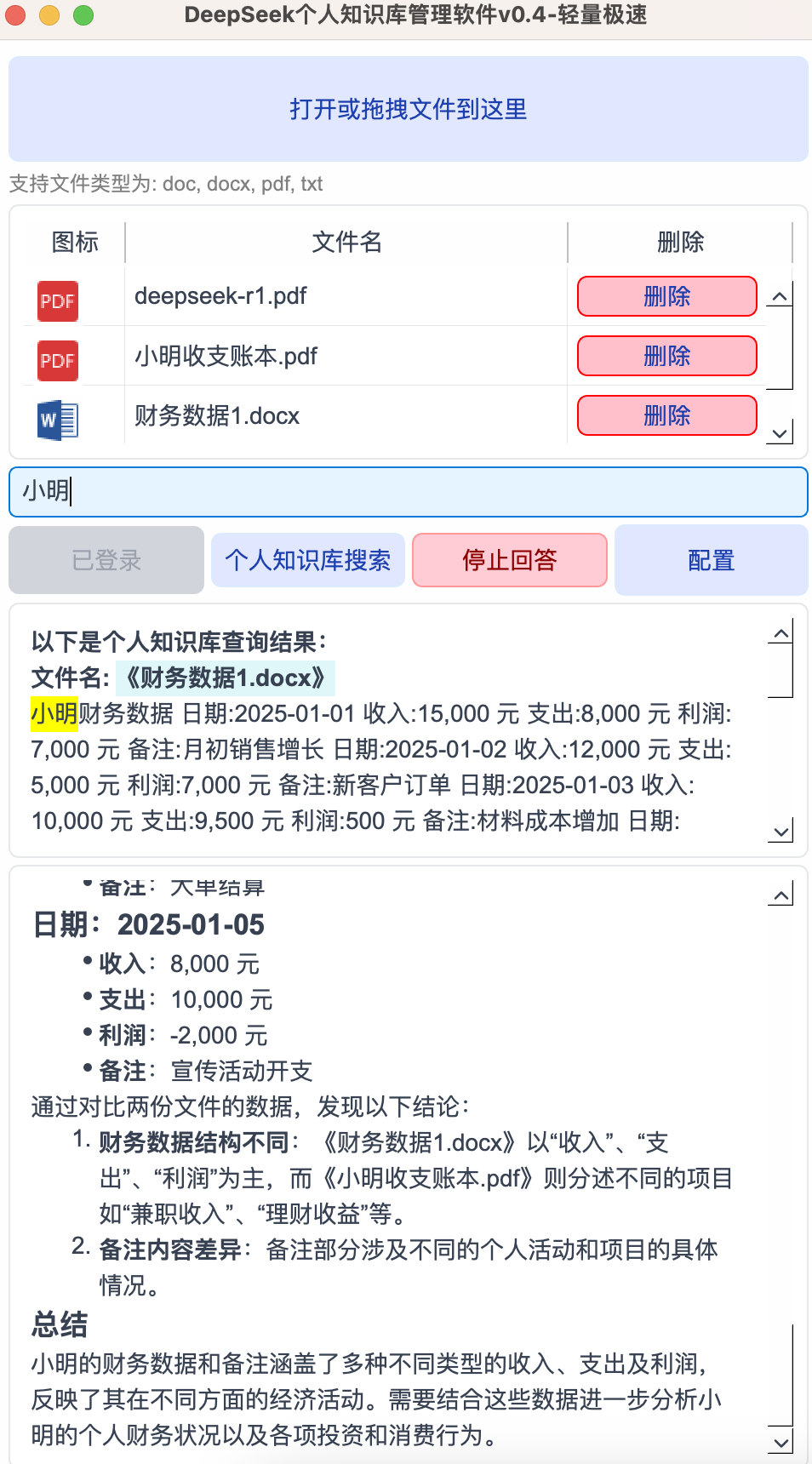

我开发的DeepSeekMine软件,就支持这样的接入功能,此软件目前是v0.4版本了,能够做到零代码接入HAI,做知识库管理比较方便,如下图所示,输入关键词小明,然后命中知识库文档,检索到上下文后自动注入到DeepSeek-R1模型(HAI提供的算力支持):

可能有些读者第一次看到此软件DeepSeekMine,还没有在自己电脑用上,获取方法在下面我的公众号回复:知识库,全部开源,不用大家花一分钱:

接下来重点说说如何配置HAI算力到上面的软件,大家点击上图软件的”配置“按钮,弹出下面的对话框,只需要修改Ollama服务器IP文本框,第二节叫大家复制的那个公网IP,大家复制到这里就行了,其他的填写内容按照下图所示一模一样即可,比如端口号:6399,大模型名称可以使用腾讯云HAI的7b或8b的了,如果想要使用7b,则填写为:deepseek-r1:7b

点击保存,保存完成后,上传自己的知识库文件,然后就可以和DeepSeek对话了,智能分析自己的知识库文件。

总结一下

本文解决了不少读者朋友遇到的一个棘手问题,就是自己的电脑运行DeepSeek推理延时(或无法推理)进而无法高效使用DeepSeek问题。

解决方案通过远程接入DeepSeek算力,使用了腾讯云HAI平台,主要优势两个:

1)对小白比较友好,零代码,简单三步直接用上DeepSeek

2)HAI平台支持全尺寸DeepSeek模型,671B满血版也能流畅运行

接入远程算力后,使用我开发的个人知识库软件DeepSeekMine,只需一步配置,就能管理起自己的知识库,比较方便。感兴趣的小伙伴可以使用此文方案去实践下。