21 DeepSeek接入多模态,个人电脑也能飞速生成高清图,完整部署步骤!

很多朋友想亲自体验在自己电脑部署大模型,然后推理得到结果,完整部署走一遍,确实能贴近和AI的距离。

之前介绍过DeepSeek-R1模型的本地部署,此模型主要是输入文字并生成文字形式的回答,属于单模态模型。今天这篇教程咱们来点不一样的,部署一个DeepSeek的多模态模型,就是在2025年1月最新发布的Janus-Pro:7B,部署后它能做:

1)理解图片,输入一张图,会生成对图片的描述信息,比较实用,很多朋友都想提取图片的内容。

2)输入文字生,成对应的高清图,也很实用。

1 部署所需电脑配置

大模型部署需要一定电脑配置,今天咱们要部署的Janus-Pro:7B大概需要24GB的GPU显存,显卡RTX、A100等系列都可以,如下所示:

这里简单科普下,大模型为啥都需要GPU显存,因为跑大模型需要缓存权重参数和中间计算状态,比如模型权重存储,激活值缓存,并且它们必须要在高速显存里,这样才能保证高效推理。一般7B参数、混合16位精度的大模型,大概需要20G~24G的显存,目前如RTX-4090显卡就支持24GB显存。

可能有的朋友看到这里就犯愁了,自己电脑不满足此配置,应该怎么解决?大家不用担心,有解决方案,可以去云算力平台。我经常用的一个就是gpugeek,它家提供了常用的GPU资源,使用简单,部署新模型也容易,比如今天大家跟着下面教程,大概10分钟就能部署DeepSeek的多模态推理模型Janus-Pro:7B。

2 完整部署步骤

第一步,打开浏览器,输入地址:

点击右上角,弹出用户界面,创建一个新的GPU实例,如下图所示,按照我的选择配置就行,RTX-4090-24G,镜像选择Miniconda:

第二步,创建完成后,通过自己电脑的命令窗口就能登录。登录时用到登录信息,在界面右下角的登录那里可以找到,点击登录出现下面界面:

然后输入到自己的电脑这里:

登录后进入我们输入nvidia-smi --list-gpus,可以查看GPU型号:

第三步,创建虚拟环境:

切换到当前新安装的环境:

下载Janus-Pro 7B 模型到本地电脑:

https://github.com/deepseek-ai/Janus.git

第四步,执行pip install -e . 安装所有依赖:

安装依赖大概需要5分钟,然后安装Gradio,直接生成文生图的操作界面:

第五步,配置镜像,下载Janus-Pro-7B,这一步的作用是下载Janus-Pro:7B模型到本地,执行下面两条命令:

export HF_ENDPOINT=https://hf-mirror.com

huggingface-cli download deepseek-ai/Janus-Pro: 7B

再执行下面命令就能启动Janus了:

python demo/app_januspro.py --device cuda

最后在自己的电脑执行下面命令,转端口到自己的电脑:

ssh -L 7860:127.0.0.1:7860 -p 48301 root@proxy-qy.gpugeek.com

接下来,在自己的电脑打开浏览器,输入:

就会出现网页界面,如下图所示,表明自己部署DeepSeek多模态大模型Janus-Pro:7B成功了:

3 使用自己部署的模型

Janus-Pro:7B支持两类能力,一是理解图片能力,就是你给它一个图,它会理解这幅图,包括图例的文字等。

接下来,我们上传一个图,测试下Janus-Pro 7B 理解图的能力,咱们把deepseek的logo图:

传给到Janus-Pro:7B模型,然后输入提问,然后开始推理,很快我们拿到了第一个推理结果,如下图所示:

字体稍微有点小,大家可以放大看看,结果比较精准。

以上我们测试了DeepSeek的Janus-Pro模型,理解图片的能力,效果不错。

DeepSeek的Janus-Pro模型除了具有看图能力外,还有文生图能力,就是给它一个提示词,它会生成对应的图片。

这个功能在页面下方,界面如图所示:

这里我们简单输入:a nice and real cat in the universal, 大概5-10秒出图,如下所示:

一次会生成5张,放大后的效果如下所示,这里我们直接使用最原生的Janus-Pro 7B部署,所以对英文提示词支持最好,当然如果要想对中文更友好的支持,只需做一个简单的中译英,然后再输入到Janus里:

我们还可以调低温度,让模型生成的图像更有创意一些,如下提示词:the face of a beautiful girl:

生成如下5张图片,其中一张效果:

大家感觉效果如何,推理速度很快,在这种推理效果下,得到这种高清图,说明Janus-Pro模型的实力。

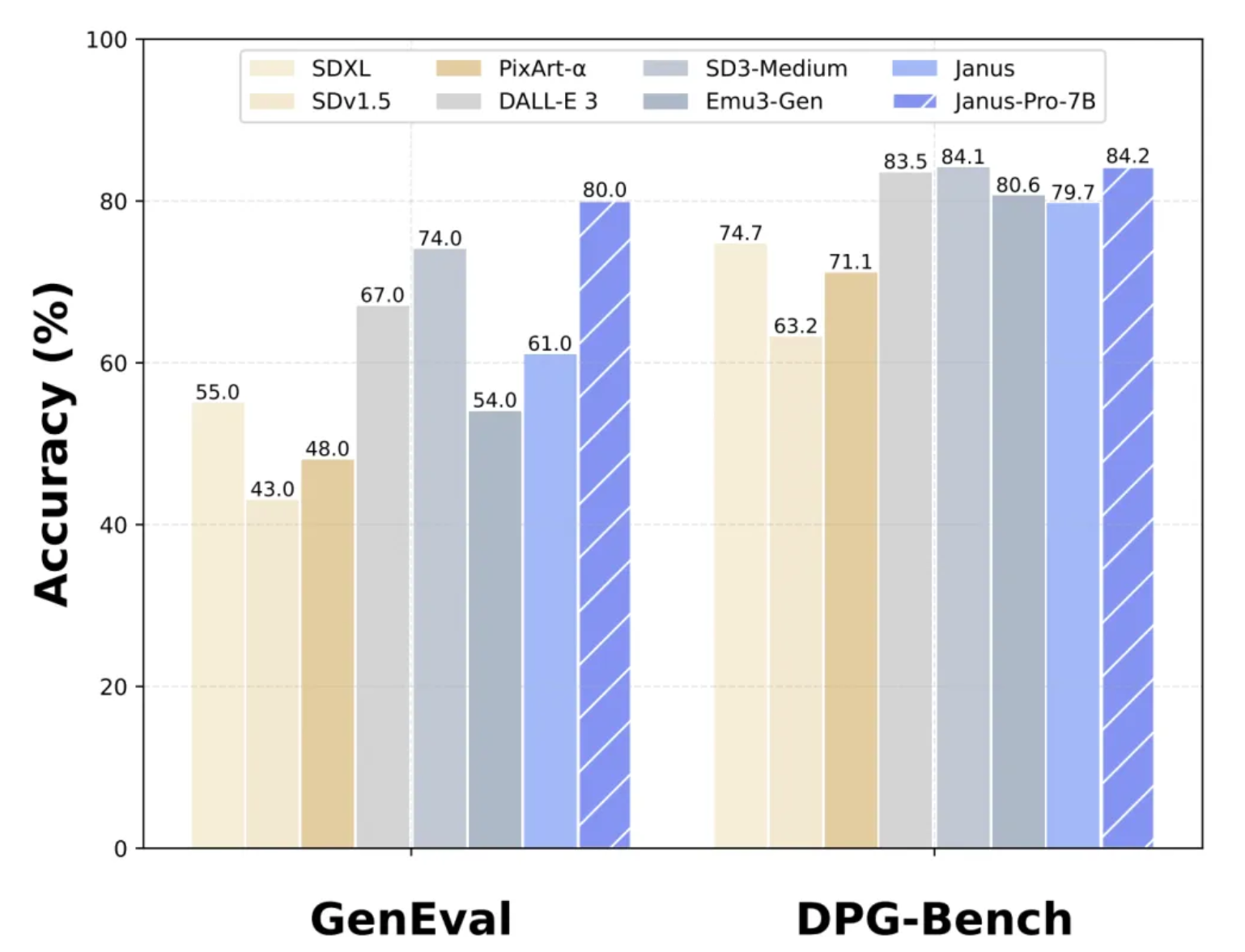

Janus-Pro 7B论文展示了目前与其他模型的对比得分,目前超过DALLE3模型,在常见数据集测试多模态得分都很高:

Janus-Pro是怎么做到的?它把看图和生图解耦分离出来,各自维护自己的编码和解码器,只在Transformer这层共享多模态信息:

最后总结一下

文章介绍了自己手动部署开源大模型的完整过程,大家按照文中步骤,差不多十来分钟就能部署好。

对于电脑配置不够的朋友,可以去gpugeek这里,点击下方阅读原文注册就送10元券,足够大家体验安装DeepSeek多模态大模型了。并且A5000服务器,目前破价到0.88元每小时,行业里没见过优惠这么大的,非常划算,想要接入远程算力的不要错过。

通过gpugeek,按照咱们这篇教程的步骤,安装DeepSeek多模态大模型后,大家便可使用它的两类能力:

1)看图说话,也就是不仅能直接提取图片内容,还能更精准的理解图;

2)文生图,体验DeepSeek的最新多模态大模型Janus-Pro生成图片

实践出真知,希望这篇完整的大模型部署教程,能够让大家更近距离的感受AI。